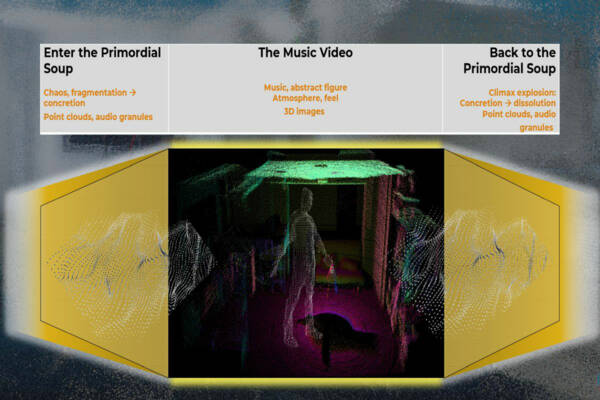

From Primordial Soup to Music Video: Das Projekt zeigt die Transformation von Chaos zu Ordnung und die Wiederauflösung nach einer emotionalen Explosion.

Wie kann man eine Synthese aus chaotischen Strukturen und Ordnung im dreidimensionalen virtuellen Raum erlebbar machen? Mit diesem Anliegen beschäftigte sich das Projektteam bei seiner Umsetzung des Projektsemester-Projektes "Ursuppe und Musikvideo - Außenraum und Innenraum". Dazu zerlegte es ein Musikvideo in seine Bestandteile.

Ein etwas anderes Musikvideo

Die Tonspur eines Musikvideos wird durch Granulation zerlegt. Die Objekte der Bilder sind als Punktewolken zu sehen und eine Person ist durch Reduktion auf ihre Grundformen und Überlagerung mit einer zur Augenblicksstimmung passenden Form dargestellt.

Ursuppe – Ordnung – Ursuppe – Wiederbeginn

Zu Beginn des Werks erscheint eine ungeordnete Punktewolke, begleitet von Audiokörnern. Diese Elemente verdichten sich immer mehr, bis der Song rein erklingt und die Räume, in denen sich die Handlung abspielt, klar erkennbar sind. Diese klare Szenerie löst sich anschließend optisch und akustisch wieder auf, bis erneut nur noch Audiokörner und eine Punktewolke übrig sind. Jetzt kann die Reise von Neuem beginnen.

Aus der Punktewolke formen sich Objekte | Copyright: Peter Szuszkiewicz

Ein Flug durch die Räume beginnt. Idealerweise hat man für das Video ein 3-D-Headset parat, denn so lassen sich die Räume in ihrer ganzen Räumlichkeit erfahren. "Jede Reise wird zur einzigartigen Erfahrung, weil in jedem Augenblick der Blickwinkel verändert werden kann und sich so jede Reise von den anderen unterscheidet", erklärt das Team.

Vision und Umsetzung

"Mit dem Projekt wollten wir die Möglichkeit ausloten, mit virtueller Technik im dreidimensionalen Raum eine Geschichte zu erzählen, das aber auf zum Teil fragmentarische Art und Weise", sagt das Projektteam. Es sollte eine Verbindung aus Chaos und Abstraktion herauskommen, konkret sollte alles nur insofern werden, als dies nötig war.

Die Umsetzung erfolge fast ausschließlich digital, nur für die Bewegungen der handelnden Person ließ sich ein Teammitglied von einem Sensor aufnehmen.

Die verwendeten Geräte und Programme:

- Unity (Aufbau der Räume, Erzeugung von Punktewolken aus 3-D-Objekten, Zusammenführung aller Einzelteile darin)

- ein iPhone 12 pro mit einem Lidar-Sensor (3-D-Scan des Raumes)

- Rokoko Studio mit einem Motion-Tracking-Anzug (3-D-Aufzeichnung der Bewegungen der Person)

- Blender (Erzeugung von bestimmten 3-D-Objekten)

- Ableton Live mit Max4Live (Audiogranulation)

- Oculus Quest2 (3-D-Ansicht)

Mario Kara

Georg Fartek

Nico Goger

Peter Scherl

Alex Vasic