Stärkung der österreichischen Innovationsfähigkeit und Forschung im Bereich Künstliche Intelligenz.

Hintergrund

Künstliche Intelligenz (KI) ist eine Schlüsseltechnologie unserer Zeit, die weitreichende und tiefgreifende Veränderungen in allen Lebensbereichen bewirken wird. Das Innovationspotenzial und die Einsatzbereiche sind vielfältig und reichen von medizinischen Diagnosen, autonomen Fahren und Überwachung von Maschinen (Predictive Maintenance) zu Beiträgen zum Klimaschutz durch CO2-Tracking.

Die Erwartungen an die KI sind also groß, allerdings schreitet die Entwicklung derzeit so schnell voran, dass es sehr schwierig geworden ist, mögliche Folgewirkungen und Gefahren abzuschätzen. Um die Entwicklungen in geordnete Bahnen zu lenken, sucht die Europäische Union daher nach Möglichkeiten, KI zu regulieren (z. B. im kommenden AI-Act EU2023) und die damit verbundenen potenziellen Risiken zu minimieren. Da konventionelle Methoden der Systemverifikation bei KI-Anwendungen an ihre Grenzen stoßen, werden dringend neue und robuste Werkzeuge zur Risikoabschätzung benötigt mit denen die von der EU vorgesehenen Konformitätsprüfungen von KI-Systemen durchgeführt werden können.

Herausforderungen

Bestehende Sicherheits- und Grundrechtsgesetze greifen bei den derzeit gebräuchlichen KI-Systemen nur bedingt. Dafür gibt es viele Gründe:

- KI-Modelle werden immer komplexer. Dies geht zu Lasten der Transparenz und erschwert es potenzielle Risiken zu erkennen.

- Modellinhärente Faktoren, wie die Struktur und der Aufbau der Modelle, tragen ebenfalls zur Intransparenz bei.

- KI-Modelle basieren auf dem Induktionsprinzip und treffen Verallgemeinerungen aufgrund von spezifischen Beispielen (d.h., sie schließen von spezifischen Trainingsdaten auf eine Gesamtheit). Dies kann zu Stereotypisierungen führen und vorhandene Vorurteile zusätzlich verstärken.

- Das Risiko von technischen Schulden (d.h., Kosten, die sich aus Nachbesserungen ergeben, wenn schnellen gegenüber effizienten Lösungen der Vorzug gegeben wird) wird häufig in Kauf genommen.

- Fehlleistungen in menschlichen Denkprozessen (kognitive Verzerrungen) sowie Mängel im Informationsaustausch können sich negativ auf KI-gestützte Entscheidungsfindungen auswirken.

Jeder der aufgezählten Punkte für sich allein ist eine Herausforderung, ihr Zusammenwirken aber verkompliziert die Situation noch zusätzlich. Ein breites Verständnis von KI-Entwicklungszyklen zu erlangen, um den kommenden Regularien gerecht zu werden, stellt die KI-Community und die Gesellschaft vor eine große Aufgabe.

Ziele

Hauptvorhaben dieses Projekts ist es, Kompetenzen aber auch Tools zu entwickeln, welche die österreichische KI-Community und das Innovationsökosystem für Regularien wie den EU-AI-Act optimal vorbereiten. Ein gleichrangiges Ziel ist es, nach neuartigen und wegweisenden Lösungen zu suchen, mit denen mehr Nachhaltigkeit erreicht und zu Klimaneutralität beigetragen werden kann. Wir legen außerdem großen Wert auf vertrauenswürdige KI und damit auf Fairness, Robustheit, Datenschutz, Sicherheit, Rechenschaftspflicht und Transparenz bei der Entwicklung von KI-Lösungen.

Resilienz gegenüber neuen Regularien aufbauen: Die Beiträge von FAIR-AI sollen die Widerstandskraft der österreichischen KI-Community erhöhen und ihre Fähigkeit stärken, künftige Entwicklungen und Regularien vorherzusehen. Mit dem EU-AI-Act kommen umfassende Dokumentationspflichten. Zudem wird die Einrichtung und Pflege eines Risikomanagementsystems verlangt. Um diese Anforderungen zu erfüllen, erarbeiten wir mit Methoden aus verschiedenen Disziplinen allgemein anwendbare Lösungen.

Neue Forschungs- und Entwicklungsprozesse ein- und in die Praxis überführen: Ein theoretisches Verständnis der neuen Regularien ist notwendig; für die Umsetzung braucht es aber auch Wissen aus der Praxis und Erfahrung. Um beides gut abzudecken, erstellen wir verschiedene Forschungsmodule. Diese sind Orientierungshilfe und weisen den Weg für innovative, nachhaltige, klimafreundliche Lösungen.

Kooperationen und Netzwerke stärken, um die Wettbewerbsfähigkeit Österreichs als Technologie- und Wirtschaftsstandort zu sichern: Viele Unternehmen und Einrichtungen mit einem Standbein in Forschung und Entwicklung unterhalten derzeit eigene auf KI-Technologien spezialisierte Forschungsteams. Oft richten sich deren Bemühungen nur auf die spezifischen Anforderungen ihres näheren Umfelds. Über dieses Umfeld hinauszugehen, kann aber den Blick für neue, innovative Lösungen öffnen und ein umfassenderes Verständnis ermöglichen. Um einen solchen Schritt zu unterstützen, strebt FAIR-AI die Einrichtung von Wissensaustauschnetzwerken an.

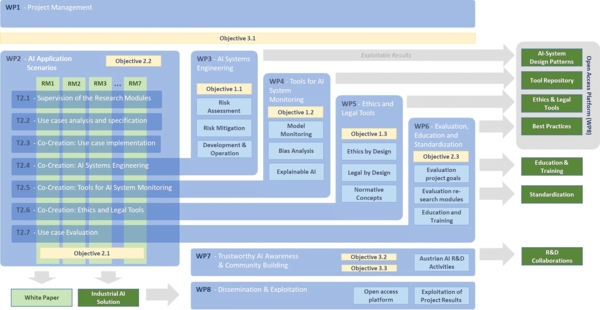

Methoden

Das Projekt verfolgt einen Co-Development-Ansatz. Wir definieren Forschungsmodule, denen die Industriepartner ihre Anwendungsfälle zuordnen und erarbeiten gemeinsam mit ihnen und den in das Projekt involvierten Forschungseinrichtungen neue Lösungen. Parallel dazu entwickeln wir Ansätze, Methoden und Werkzeuge für vertrauenswürdige KI. Die Ergebnisse werden mit den Projektzielen abgeglichen, für die Verwendung in Aus- und Weiterbildung aufbereitet und über eine Open-Access-Plattform zugänglich gemacht.

Fördergeber

Sie wollen mehr wissen? Fragen Sie nach!

Forschungsgruppenleiter

Forschungsgruppe Media Computing

Institut für Creative\Media/Technologies

Department Medien und Digitale Technologien

- AIT Austrian Institute of Technology GmbH

- JOANNEUM RESEARCH Forschungsgesellschaft mbh

- Fachhochschule Technikum Wien

- AW

- Technische Universität Wien

- Wirtschaftsuniversität Wien

- SCCH

- Austrian Standards International (ASI)

- eutema

- Research Institute

- Semantic Web Company

- Siemens

- Brantner

- FABASOFT

- SCHEIBER

- MeinDienstplan

- Dibit

- Messtechnik GmbH

- Onlim

- Austrian Standards

- Women in AI