Alltagsgeräte als nützliche Helfer und Assistenzsysteme in Notsituationen.

Hintergrund

Mit steigender Lebenserwartung und dem Wunsch vieler älterer Menschen, möglichst lange selbstständig zu wohnen, wird eine rechtzeitige und verlässliche Notfallerkennung immer wichtiger, um sowohl Sicherheit als auch Autonomie zu gewährleisten. Besonders Sturzereignisse sind ein großes Risiko: Wenn Hilfe verzögert eintrifft, führen sie häufig zu Krankenhausaufenthalten, langfristigen Verletzungen oder sogar zum Verlust der Selbstständigkeit. Zwar existieren bereits zahlreiche Lösungen zur Notfallbenachrichtigung – wie Notrufknöpfe, tragbare Sensoren oder Videoüberwachung – doch jede dieser Methoden weist erhebliche Nachteile auf. Notrufknöpfe werden im Ernstfall oft nicht getragen oder vergessen, unimodale Sensorsysteme sind wenig robust, und eine dauerhafte Videoüberwachung wirft erhebliche Datenschutzbedenken auf. Diese Faktoren tragen dazu bei, dass die Akzeptanz gerade bei denjenigen gering bleibt, die am meisten von solchen Systemen profitieren würden.

Projektinhalt

Smart Companion wurde entwickelt, um die Herausforderungen der Sturzerkennung auf neue Weise zu behandeln. Das System erweitert einen handelsüblichen Saugroboter um die Funktionen der liegenden-Person-Erkennung und der verbalen Kommunikation und verbindet damit alltäglichen Nutzen mit unterstützenden Notfallfunktionen. Während der Reinigung navigiert der Roboter selbstständig durch die Wohnung und analysiert dabei die von seiner Kamera aufgenommenen Bilder. Wird eine liegende Person erkannt, versucht der integrierte Sprachassistent ein Gespräch zu beginnen, um festzustellen, ob Hilfe benötigt wird. Erfolgt keine Reaktion oder wird ein Hilfebedarf bestätigt, werden die Notdienste benachrichtigt.

Aufbauend auf den Erkenntnissen von Smart Companion 1 wurde das aktuelle System im Rahmen eines Human Centered Design (HCD)-Prozesses entwickelt, bei dem die Bedürfnisse und Erfahrungen der Nutzer im Mittelpunkt stehen. Die verbale Interaktion bewahrt die Handlungshoheit der Nutzer und dient zugleich als Korrekturmechanismus. Der Alarm kann vom Nutzer zurückgewiesen werden, wenn keine Hilfe erforderlich ist, oder es kann aktiv Unterstützung angefordert werden, falls weder Telefon noch Notrufknopf erreichbar sind.

Zusätzliche Suchläufe erhöhen die Überwachungsfrequenz, die Bildanalyse erfolgt vollständig lokal. Sprachbefehle ermöglichen es den Nutzern, die Notfallkommunikation jederzeit zu beenden und den Roboter zu seiner Ladestation zurückzuschicken. Zeitpläne und Beobachtungsbereiche werden vom Nutzer definiert, wodurch ein Sicherheitsnetz entsteht, das weder spezielle Geräte noch eine dauerhafte Videoüberwachung erfordert.

System und Entwicklung

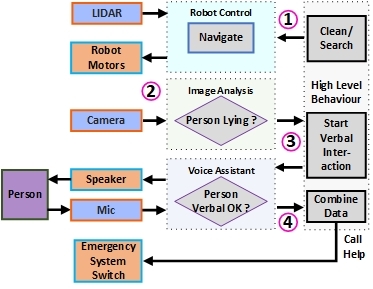

Das System lässt sich in vier Hauptkomponenten unterteilen: Robotersteuerung und Hardware, Bildanalyse, Sprachassistenz sowie ein übergeordnetes Verhaltenskontrollprogramm. Die nachstehende Abbildung zeigt einen Systemüberblick: Während eines Reinigungs- oder Suchlaufs (1) überwacht der Roboter in regelmäßigen Abständen den Wohnbereich des Nutzers. Dabei nimmt er Bilder auf (2). Erkennt die Bildanalyse eine liegende Person, aktiviert der Roboter seinen Sprachassistenten, um mit der Person verbal zu kommunizieren und festzustellen, ob tatsächlich Hilfe benötigt wird (3). Dies erhält die Kontrolle beim Nutzer und verhindert Fehlalarme. Fordert der Nutzer Hilfe an oder reagiert nicht, wird ein Notdienst benachrichtigt, der ein Bild der liegenden Person zur weiteren Einschätzung der Situation erhält (4). Die Sprachkommunikation ermöglicht es den Nutzern außerdem, aktiv um Hilfe zu rufen, ohne darauf warten zu müssen, dass der Roboter sie findet. Zusätzlich kann über die Sprachschnittstelle auch die normale Funktion des Roboters gesteuert werden.

Roboter Steuerung und Hardware

Das Smart-Companion-System basiert auf einem handelsüblichen Saugroboter, der eine kostengünstige autonome Mobilität ermöglicht. Ausgestattet mit Lidar und einer Frontkamera kartiert und navigiert der Roboter Innenräume mithilfe seiner integrierten SLAM-Funktionalität. Über die Open-Source-Schnittstelle Valetudo können Navigationsbefehle gesendet, Reinigungs- oder Suchläufe definiert und bestimmte Bereiche aus Gründen des Datenschutzes ausgeschlossen werden.

Bildverarbeitung

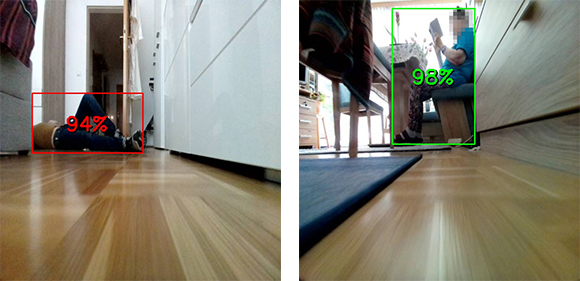

Die RGB-Kamera des Roboters erfasst während der Reinigungs- und Suchläufe alle zwei Sekunden Bilder. Um redundante Daten zu vermeiden, werden nahezu identische Aufnahmen vor der Analyse herausgefiltert. Die Erkennung liegender Personen basiert auf dem YOLOv8-Convolutional-Neural-Network (CNN). Dabei wurde die Klassifikationsschicht des Modells angepasst und durch drei neue Klassen ersetzt („Person“, „liegende Person“, „keine Person“). Die unteren Schichten wurden teilweise eingefroren, um generalisierbare Merkmale zu bewahren. Das Modell wurde auf einer Kombination aus öffentlichen und eigenen Datensätzen (21.000 Bilder) feinabgestimmt und mit separaten Testdatensätzen (5.000 Bilder) evaluiert. Um den Projektanforderungen gerecht zu werden, enthält der eigene Datensatz Bilder der Roboterkamera, da diese spezifische Perspektive in öffentlichen Datensätzen – insbesondere für liegende Personen – unterrepräsentiert ist. Eine Multi-View-Analyse erhöht die Zuverlässigkeit: Erkennungen werden nur dann bestätigt, wenn mehrere Bilder oder hohe Konfidenzwerte dasselbe Ereignis anzeigen. Die untenstehenden Abbildungen zeigen die Erkennung einer liegenden Person (roter Rahmen) mit einem Score von 0,92 sowie einer stehenden Person (grüner Rahmen) mit einem Score von 0,98.

Sprach Assistenz

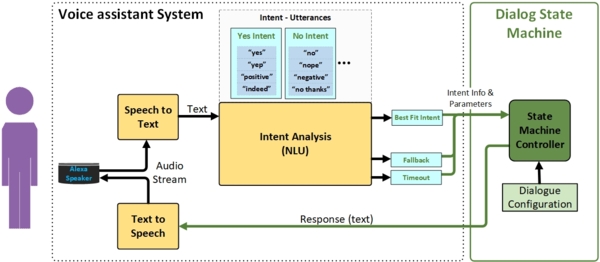

Voice Service (AVS) in der Cloud verbunden ist. Mithilfe des Alexa Skills Kit werden Äußerungen in Text transkribiert und mit vordefinierten Äußerungen verglichen. Diese werden zu Intents zusammengefasst, um ihre Bedeutung zu interpretieren (z. B. werden „Hilfe“, „Ich brauche Unterstützung“, „Ruf jemanden an“ dem Intent help zugeordnet). Die Intents werden von einer Dialog-Zustandsmaschine (Dialog State Machine, DSM) verarbeitet, welche den Gesprächsfluss steuert und die Systemreaktionen anpasst.

Das Dialogmodell unterscheidet zwischen erwarteten, unerwarteten und fehlenden Antworten und ermöglicht dadurch Nachfragen oder Wiederholungen. Dies stellt eine robuste Kommunikation sicher – auch unter Stress oder bei mehrdeutigen Eingaben. Die Sprachinteraktion bewahrt die Handlungshoheit der Nutzer, indem sie Fehlalarme zurückweisen, Notfälle bestätigen oder aktiv Hilfe anfordern können. Das Modell umfasst 398 Äußerungen, die in 21 Intents und über 40 Dialogzustände gegliedert sind.

Verhaltens Zustands Maschine

Die Verhaltenszustandsmaschine koordiniert das gesamte System, indem sie Informationen aus Navigation, Bildverarbeitung und Sprachinteraktion integriert. Sie definiert die Betriebszustände des Roboters (z. B. Reinigung, Suche, potenzieller Notfall, Notfallmodus) und steuert die Übergänge basierend auf Sensordaten und Benutzerreaktionen. Außerdem überwacht sie den Zustand der Komponenten, wiederholt fehlgeschlagene Aktionen und passt das Verhalten dynamisch an, wenn Abweichungen erkannt werden, um eine robuste Systemsteuerung zu gewährleisten.

Ergebnisse

Nach Abschluss des nutzerzentrierten Designs wurde der Prototyp in einer Feldstudie mit sechs älteren Personen getestet, die allein und unabhängig lebten. Jede Testphase dauerte einen Monat, die Teilnehmenden waren zwischen 60 und 80 Jahre alt. Zu Beginn wurde das System vorgestellt und individuelle Zeitpläne sowie Überwachungsbereiche für Suchläufe eingerichtet. Die Teilnehmenden dokumentierten ihre Erfahrungen in täglichen Protokollen, außerdem wurden vor und nach der Testphase Interviews durchgeführt. Zusätzlich wurden Liegensimulationen durchgeführt, um die Teilnehmenden mit den Notfallprozeduren des Roboters vertraut zu machen und gezieltes Feedback zu sammeln. Über alle Testläufe hinweg wurden mehr als 100.000 Bilder aufgezeichnet. Zusammen mit den Nutzerprotokollen und automatisierten Systemlogs dienten diese Daten der iterativen Verbesserung des Dialogmodells, des Roboterverhaltens und der CNN-Leistung.

Über den gesamten Zeitraum von sechs Monaten zeigte das System einen stabilen Betrieb. Es trat nur ein einziger Fehlalarm auf, verursacht durch eine Fehlklassifizierung, als die Nutzerperson nicht anwesend war. In den Simulationen sowie zusätzlichen Labortests erwies sich die Multi-View-Erkennung liegender Personen als robust und zuverlässig. Die abschließende Nutzerbefragung ergab sehr positive Bewertungen: Das Vertrauen in die Fähigkeit zur Liegendetektion lag im Durchschnitt bei 4,8/5, das Vertrauen in den Datenschutz bei 4,9/5 und der wahrgenommene Nutzen bei 5/5. Trotz der kleinen Stichprobe deckte die Studie 184 Tage kontinuierlicher Tests im häuslichen Umfeld mit 208 Such- und Reinigungsdurchläufen ab und liefert somit belastbare Hinweise darauf, dass das System unter realen Bedingungen zuverlässig funktioniert. In Kombination mit der iterativen, nutzerzentrierten Entwicklung belegen diese Ergebnisse eine hohe technische Zuverlässigkeit und eine starke Nutzerakzeptanz.

Danksagung

Die wesentliche technologische Innovation des Smart Companion Systems ist die Kombination mehrerer intelligenter Dienste. Durch das Zusammenspiel von Daten aus verschiedenen Quellen (z.B. Sensoren und Aktoren) werden neue Wege in der Mensch-Maschine-Interaktion beschritten und die Grundlagen für die nächste Generation von persönlichen Assistenzsystemen geschaffen. Die an dem Projekt beteiligten Partner profitieren in vielerlei Hinsicht von den Ergebnissen des Projekts. Die FH St. Pölten leitet die Europäische Hochschulinitiative E³UDRES² mit mehreren Partnerhochschulen und sieht in Smart Companion einen wichtigen Anknüpfungspunkt für internationale Forschungskooperationen mit ähnlicher thematischer Ausrichtung. Die Bosch AG stärkt mit diesem Projekt ihre Position als europäischer Hersteller von Staubsaugerrobotern und Smart Home Systemen. Die Akademie für Altersforschung am Haus der Barmherzigkeit ist in den Entwicklungsprozess vollumfänglich involviert, und leistet mit seiner Expertise wesentliche Beiträge zu ethischen Fragen und bei der Erreichung hoher ethischer Standards. Der Arbeiter-Samariter- Bund Gruppe Linz ist ein Anbieter von Notrufsystemen und benötigt dringend technische Lösungen, um Stürze zuverlässig zu erkennen.

Gefördert im Programm „IKT der Zukunft“ vom Bundesministerium für Klimaschutz, Umwelt, Energie, Mobilität, Innovation und Technologie (BMK)

Smart Companion im ORF NÖ

Publikationen

Sie wollen mehr wissen? Fragen Sie nach!

FH-Dozent

Department Medien und Digitale Technologien

- BOSCH Robert Bosch AG, Wien

- Akademie für Altersforschung am Haus der Barmherzigkeit, Wien

- Arbeiter-Samariter-Bund, Gruppe Linz